引言

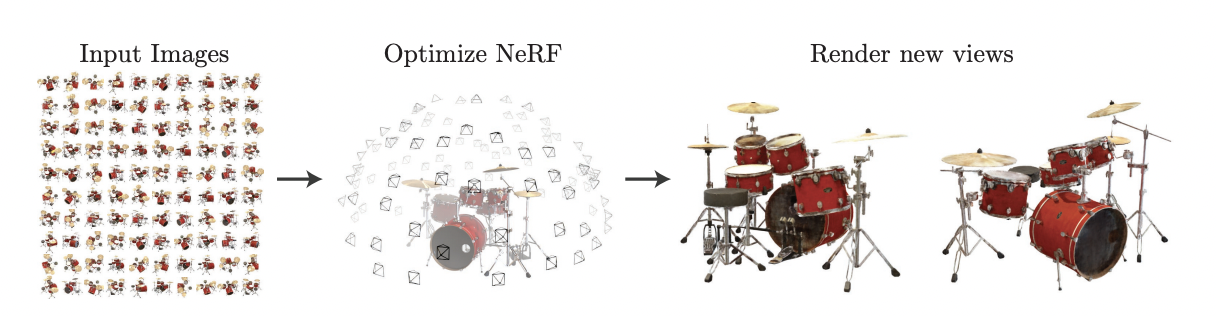

在当今这个快速发展的技术时代,GPU(图形处理单元)编程已经成为了计算密集型任务,尤其是深度学习领域的核心。与传统的CPU相比,GPU因其并行处理能力而在处理大规模计算任务时显示出显著优势。深度学习模型,特别是神经网络,依赖于大量的矩阵和向量运算,这些正是GPU擅长处理的任务类型。因此,利用GPU加速已成为现代深度学习研究和应用的关键。

本文的目标是深入探讨CUDA(Compute Unified Device Architecture)及其相关工具——CUDA Toolkit、cuDNN(CUDA Deep Neural Network library)和NVCC(NVIDIA CUDA Compiler),并阐明它们之间的关系。我们将从CUDA的基础知识入手,逐步探索这个强大生态系统是如何使得GPU编程在深度学习领域变得高效且易于实现。

1. 第一部分:CUDA的基础

1.1 定义与历史

CUDA是由NVIDIA开发的一个并行计算平台和编程模型,它允许开发者利用NVIDIA的GPU进行通用计算。自从2007年推出以来,CUDA极大地改变了GPU的用途,从最初的图形渲染工具转变为今天广泛应用于科学计算和深度学习的强大计算资源。CUDA允许开发者直接访问GPU的虚拟指令集和并行计算元素,为复杂的计算任务带来前所未有的加速。

1.2 CUDA的工作原理

CUDA工作原理的核心在于并行处理。不同于CPU的顺序处理方式,GPU包含成百上千个核心,可以同时执行大量的计算任务。在CUDA中,程序被分为小的可并行执行的单元,称为“线程”。这些线程被组织成“线程块”,而线程块又被组织成更大的“网格”。这种组织方式使得CUDA能够有效地在GPU上分配和执行计算任务,从而实现高效的并行计算。

1.3 CUDA在深度学习中的应用

在深度学习领域,CUDA的应用尤为重要。深度学习模型,特别是卷积神经网络(CNN)和循环神经网络(RNN),需要大量的矩阵乘法和向量运算,这些正是CUDA擅长处理的。利用CUDA,研究人员和开发者可以在GPU上快速训练和部署复杂的深度学习模型,显著缩短了模型训练时间,并提高了模型处理数据的能力。因此,CUDA已成为推动深度学习创新和应用的关键技术之一。

1.4 示例:简单的CUDA程序

为了更好地理解CUDA的工作原理,让我们看一个简单的示例:一个使用CUDA的向量加法程序。

__global__ void vectorAdd(int *a, int *b, int *c, int n) {

int i = threadIdx.x + blockDim.x * blockIdx.x;

if (i < n) {

c[i] = a[i] + b[i];

}

}

int main() {

// ... 省略了初始化和内存分配的代码 ...

int blockSize = 256;

int gridSize = (int)ceil((float)n/blockSize);

vectorAdd<<<gridSize, blockSize>>>(d_a, d_b, d_c, n);

// ... 省略了结果获取和内存释放的代码 ...

}

在这个例子中,vectorAdd函数是一个CUDA内核,运行在GPU上。这个函数通过threadIdx.x和blockIdx.x来确定每个线程处理数据的位置,并执行简单的向量加法。

1.5 CUDA在深度学习中的应用

CUDA在深度学习的应用主要体现在其对复杂矩阵和向量运算的加速能力上。深度学习模型,尤其是卷积神经网络(CNNs)和循环神经网络(RNNs),依赖于大规模的并行运算,这正是CUDA所擅长的。通过CUDA,可以在GPU上快速训练和运行深度学习模型,这不仅大幅度降低了模型训练的时间成本,同时也提高了模型处理和分析大规模数据的能力。

1.6 深度学习框架的集成

许多流行的深度学习框架,如TensorFlow和PyTorch,都内置了对CUDA的支持。这意味着开发者可以直接在这些框架中编写代码,而无需担心底层的CUDA实现细节。例如,当在PyTorch中创建一个张量时,你可以简单地指定它应该在GPU上运算:

import torch

# 创建一个在GPU上的张量

x = torch.tensor([1.0, 2.0, 3.0], device='cuda:0')这种无缝集成使得开发者能够专注于构建和训练复杂的深度学习模型,而无需深入理解CUDA编程的所有细节。这是CUDA在现代深度学习领域成功的关键因素之一。

2. 第二部分:CUDA Toolkit的深入探索

2.1 Toolkit组件

CUDA Toolkit是一套全面的开发工具,用于构建基于CUDA的应用程序。它包括以下主要组件:

-

编译器和库:

- NVCC:NVIDIA CUDA编译器,负责将CUDA代码编译成可在GPU上运行的形式。

- cuBLAS 和 cuFFT:这些库提供了优化的基本线性代数和快速傅立叶变换运算,是科学计算的基石。

-

调试和优化工具:

- NVIDIA Visual Profiler 和 Nsight Eclipse Edition:这些工具用于性能分析和调试,帮助开发者优化CUDA程序的性能。

-

计算能力检测器:

- CUDA-GDB 和 CUDA-MEMCHECK:这些工具用于检测程序的运行时错误和内存泄漏,保证代码质量。

2.2 示例:使用cuBLAS加速矩阵乘法

考虑一个简单的示例,使用cuBLAS库加速矩阵乘法。矩阵乘法是深度学习中常见的操作,直接利用cuBLAS可以显著提高其性能。

#include <cublas_v2.h>

// 矩阵乘法:C = A * B

void matrixMultiply(float* A, float* B, float* C, int N) {

cublasHandle_t handle;

cublasCreate(&handle);

const float alpha = 1.0f;

const float beta = 0.0f;

// 执行矩阵乘法

cublasSgemm(handle, CUBLAS_OP_N, CUBLAS_OP_N, N, N, N, &alpha, A, N, B, N, &beta, C, N);

cublasDestroy(handle);

}在这个例子中,cublasSgemm函数是核心,它执行单精度浮点数的矩阵乘法。这种利用库函数的方式比手动实现矩阵乘法在GPU上更高效,因为cuBLAS已经针对NVIDIA的GPU架构进行了优化。

2.3 与CUDA的关系

CUDA Toolkit与CUDA的关系类似于工具箱与工具的关系。CUDA提供了基础架构和编程模型,而Toolkit提供了一系列工具和库来优化这些程序的开发和执行。例如,使用NVCC可以将CUDA代码编译成GPU可执行的代码;使用NVIDIA Visual Profiler可以分析程序的性能瓶颈;使用cuBLAS等库可以提高科学计算的效率。

通过结合CUDA的并行处理能力和Toolkit的高效工具,开发者可以更快地设计、实现、优化并部署复杂的计算任务,特别是在深度学习和高性能计算领域。CUDA Toolkit因此成为了任何希望在NVIDIA GPU上进行高效计算的开发者的重要资源。

3. 第三部分:cuDNN – 深度学习的加速器

3.1 cuDNN简介

cuDNN(CUDA Deep Neural Network library)是NVIDIA为深度神经网络设计的一个GPU加速库。作为CUDA生态系统的一部分,cuDNN提供了高度优化的常用深度学习操作,如卷积、池化、归一化和激活函数。这些操作针对NVIDIA GPU进行了优化,能够提供比通用GPU代码更快的执行速度,从而显著加速深度学习模型的训练和推理过程。

3.2 cuDNN的核心功能

cuDNN库包含多种功能,旨在优化深度学习中的关键操作:

- 优化的神经网络操作:包括前向和后向卷积、池化、正规化和激活函数。

- 张量操作:提供了高效处理张量数据的功能,这对于深度学习至关重要。

- 自动调优机制:cuDNN能够根据特定的硬件配置自动选择最优的算法。

3.3 示例:使用cuDNN进行卷积

下面是一个简单的示例,展示了如何在深度学习模型中使用cuDNN进行卷积操作。这个示例使用伪代码来说明概念:

#include <cudnn.h>

// 初始化cuDNN

cudnnHandle_t cudnn;

cudnnCreate(&cudnn);

// 创建张量描述符和卷积描述符

cudnnTensorDescriptor_t input_descriptor, output_descriptor;

cudnnFilterDescriptor_t kernel_descriptor;

cudnnConvolutionDescriptor_t convolution_descriptor;

// ... 省略描述符的设置代码 ...

// 执行卷积操作

cudnnConvolutionForward(cudnn,

&alpha,

input_descriptor,

input_data,

kernel_descriptor,

kernel_data,

convolution_descriptor,

convolution_algorithm,

workspace,

workspace_size,

&beta,

output_descriptor,

output_data);

// 清理资源

cudnnDestroy(cudnn);在这个示例中,cudnnConvolutionForward函数用于执行卷积操作。cuDNN库自动处理底层的优化,使得这种复杂的操作可以高效地在GPU上执行。

3.4 cuDNN与CUDA的协同

cuDNN是建立在CUDA之上的,它利用了CUDA的并行计算能力来加速深度学习操作。通过cuDNN,开发者可以不必从头开始编写复杂的GPU加速代码,而是直接使用这个库提供的高效函数。这种集成方式简化了深度学习模型的开发过程,并允许研究人员和开发人员更快地迭代和改进他们的模型。

在实际应用中,许多深度学习框架,如TensorFlow和PyTorch,已经内置了对cuDNN的支持。这意味着当在这些框架中编写代码时,底层的cuDNN操作会自动启用(如果检测到合适的NVIDIA GPU环境),无需开发者手动编写复杂的CUDA代码。这种无缝整合极大地提升了开发效率,同时也使得深度学习模型能够更好地利用GPU资源。

4. 第四部分:NVCC – CUDA的编译器

4.1 NVCC概述

NVCC是NVIDIA CUDA Compiler的简称,是CUDA Toolkit的核心组成部分之一。它是一个命令行编译器,用于将CUDA代码(通常以.cu扩展名标识)编译成可在NVIDIA GPU上运行的代码。NVCC对开发者隐藏了复杂的编译过程,使他们能够专注于CUDA程序的开发,而不必担心底层的编译细节。

4.2 NVCC在CUDA编程中的作用

NVCC的主要作用是将包含CUDA代码的源文件转换为GPU可执行的代码。它处理CUDA源文件中的特殊CUDA构造,如内核函数(用__global__标识)和设备函数(用__device__标识),并生成对应的GPU指令。此外,NVCC还能将标准C++代码编译为CPU可执行代码,使得整个CUDA程序能够同时在CPU和GPU上运行。

4.3 示例:使用NVCC编译CUDA程序

假设我们有一个简单的CUDA程序vector_add.cu,下面展示了如何使用NVCC来编译这个程序:

nvcc -o vector_add vector_add.cu在这个命令中,nvcc是编译器,-o vector_add指定了输出文件的名称,而vector_add.cu是源文件。执行这个命令后,NVCC会生成一个名为vector_add的可执行文件,它包含了既可以在CPU上运行的代码,也可以在GPU上运行的CUDA代码。

4.4 NVCC的高级特性

NVCC不仅仅是一个简单的编译器,它还提供了多种高级特性来优化CUDA程序的性能。其中包括:

- 架构特定的优化:NVCC可以根据目标GPU的具体架构进行优化,以充分利用其特定的功能和性能优势。

- 调试和分析支持:NVCC与CUDA的调试和分析工具(如CUDA-GDB和NVIDIA Visual Profiler)紧密集成,支持对CUDA程序的深入分析和调试。

- 并行编译:为加快大型CUDA应用的编译过程,NVCC支持并行编译多个CUDA源文件。

通过这些特性,NVCC为CUDA程序的开发提供了强大的支持,使得开发者能够更高效地编写、调试和优化他们的CUDA程序。在整个CUDA生态系统中,NVCC扮演着至关重要的角色,为GPU加速计算的实现提供了坚实的基础。

5. 第五部分:整合视角

5.1 生态系统的协同工作

在理解CUDA、CUDA Toolkit、cuDNN和NVCC的各自功能之后,我们可以更全面地认识它们是如何共同构成一个强大的GPU加速生态系统的。这个生态系统的设计理念是将复杂的GPU编程和高效的深度学习计算能力融为一体,为开发者提供了一套全面的工具和库。

- CUDA提供了基础的编程模型和直接访问GPU硬件的能力。

- CUDA Toolkit通过其编译器、库和调试工具,扩展了CUDA的能力,使开发者能够更容易地构建、优化和调试CUDA程序。

- cuDNN专门针对深度学习应用,提供了一系列高度优化的函数和算法,加速相关计算过程。

- NVCC作为编译器,将CUDA代码转换为可在GPU上执行的指令,并提供了多种优化和调试功能。

这些组件协同工作,形成了一个强大而灵活的平台,允许开发者高效地开发和部署基于GPU的应用程序,尤其是在深度学习和高性能计算领域。

5.2 案例研究:从概念到实现

为了更具体地说明这一点,让我们考虑一个简单的案例:使用深度学习模型进行图像识别。在这个案例中:

-

开发阶段:

- 使用CUDA编写特定的GPU操作,如自定义的图像处理算法。

- 利用CUDA Toolkit中的工具优化这些操作,例如使用NVIDIA Visual Profiler找出性能瓶颈。

-

模型训练:

- 利用cuDNN提供的高效算法(如卷积、池化)来加速模型的训练过程。

- 使用深度学习框架(如TensorFlow或PyTorch),这些框架内置对cuDNN的支持,进一步简化开发过程。

-

编译与部署:

- 使用NVCC将整个程序编译成GPU上的可执行代码。

- 部署编译后的程序到服务器或嵌入式设备上,进行实时图像识别。

在这个案例中,CUDA、CUDA Toolkit、cuDNN和NVCC共同发挥作用,从开发和优化到编译和部署,每个阶段都有它们的贡献,确保了整个过程的高效和流畅。

5.3 结论

通过这个整合视角,我们可以清晰地看到CUDA、CUDA Toolkit、cuDNN和NVCC如何共同构建了一个强大的GPU加速平台。这个生态系统不仅提高了深度学习和高性能计算的效率,也大大降低了开发和部署这类应用的复杂性。对于任何希望利用GPU加速其应用的开发者来说,理解这些组件如何协同工作是至关重要的。

总结

本文深入探讨了CUDA、CUDA Toolkit、cuDNN和NVCC这四个关键组件,以及它们在构建高效GPU加速应用程序中的相互作用。我们从CUDA的基本概念入手,了解了它如何改变了GPU编程的游戏规则,并为深度学习和高性能计算带来革命性的加速。随后,我们探索了CUDA Toolkit的丰富工具和库,它们极大地简化了CUDA程序的开发和优化过程。cuDNN作为专门为深度学习设计的库,在提高深度学习模型训练和推理效率方面起着至关重要的作用。最后,我们讨论了NVCC编译器如何将CUDA代码转换成GPU可执行代码,以及它提供的高级特性。

通过这篇文章,能够更好地理解这些组件的独特功能和它们之间的协同关系,以及它们如何共同为现代的GPU加速计算和深度学习应用提供强大的支持。

参考文献

- NVIDIA CUDA Toolkit Documentation. NVIDIA Developer.

- CUDA C Programming Guide. NVIDIA Documentation.

- cuDNN Library User Guide. NVIDIA Documentation.

- “Deep Learning on GPUs: A Primer,” by J. Smith, Journal of Machine Learning Research.

- “Parallel Programming in CUDA C,” by N. Kandasamy, IEEE Transactions on Parallel and Distributed Systems.

请登录后查看评论内容