曼哈顿世界假设

概念

曼哈顿世界假设是一种常见的室内场景描述方法,指的是大部分室内场景中的物体、墙壁、天花板和地板等结构,可以用一个三维笛卡尔坐标系来表示,该坐标系的轴与地板、天花板以及四面墙壁平行。

曼哈顿世界假设在计算机视觉和室内场景重建领域中得到广泛的应用,因为它可以描述室内场景中的结构和物体之间的几何关系,并且可以方便地进行建模和联合优化,同时也符合人类对室内场景的感知和理解。

在室内场景重建中,曼哈顿世界假设通常作为先验知识来指导三维重建。通过曼哈顿世界假设,我们可以推导出室内场景中各个平面之间的空间关系和角度关系,从而可以更精确地进行3D建模和重建。

文章阅读

1.引言

输入在室内场景采集的图像序列,本论文希望能生成该室内场景的三维模型。提出了一种新的室内场景重建方法,该方法基于曼哈顿世界假设。该方法旨在解决从多视图图像重建3D室内场景的挑战。

1.1 现存问题

许多以前的工作已经在纹理对象上显示出令人印象深刻的重建结果,但它们仍然难以处理室内场景中常见的低纹理平面区域。

传统方法一般通过MVS(Multi-View Stereo) [1,2] 做场景重建,首先根据多视角匹配来估计每个视角的深度图,然后将每个视角的深度在三维空间中做融合。这类方法最大的问题在于难以处理弱纹理区域、非朗伯表面,原因是这些区域难以做匹配,从而导致重建不完整。

要么使用平面估计作为后处理步骤来修复低纹理区域中缺失的深度值,要么在立体匹配或深度优化中集成平面约束。然而,它们都专注于优化每个视图的深度图,而不是 3D 空间中的完整场景模型。

1.2 解决问题

解决这个问题的一种方法是在基于多视图立体的方法中将平面约束合并到深度图估计中,但是每视图平面估计和深度优化缺乏效率和多视图一致性。在这项工作中,我们表明平面约束可以方便地集成到最近的基于隐式神经表示的重建方法中。具体来说,我们使用 MLP 网络将带符号的距离函数表示为场景几何。基于曼哈顿世界假设,采用平面约束来规范由 2D 语义分割网络预测的地板和墙壁区域的几何形状。

为了解决不准确的分割问题,我们使用另一个 MLP 对 3D 点的语义进行编码,并设计了一种新颖的损失,共同优化 3D 空间中的场景几何和语义。

2.介绍

本文的introduction部分介绍了基于多视角图像重建3D室内场景中的主要挑战,即在处理低纹理、平面区域时,现有的方法存在困难。此外,作者提出了一种基于曼哈顿世界假设的新型室内场景重建方法,该方法利用平面区域内的语义信息来指导几何重建,并在学习从2D语义分割结果中的3D语义信息的同时,共同优化3D语义和几何,提高对不准确2D分割的鲁棒性。

用隐式神经表示表示 3D 场景的几何和语义,这使得基于曼哈顿世界假设的 3D 空间中几何重建和语义分割的联合优化成为可能。

实验结果表明,所提出的方法能够在保持非平面区域细节的同时重建准确和完整的平面,并在公共数据集上显著优于现有最先进的方法。此外,文中还介绍了一些与本文相关的背景知识,如深度学习库PyTorch[35]、3D点云特征学习方法PointNet36、数据集ScanNet和7-Scenes[5],以及语义分割方法[4]等。

贡献如下:

• 一种新颖的场景重建方法,将曼哈顿世界约束集成到隐式神经表示的优化中。

• 优化语义标签和场景几何的新型损失函数。

• 与ScanNet 和7-Scenes 上最先进的方法相比,重建质量显着提高。

3.相关工作

文章回顾了与本文相关的研究领域。

3.1 MVS

首先,它讨论了多视图立体声(MVS)方法,这些方法采用两阶段流程进行多视图3D重建:首先基于MVS估计每个图像的深度图,然后执行深度融合以获得最终的重建结果。然而,这些方法在处理无纹理区域时表现不佳。为了解决这个问题,一些工作通过深度学习技术改进了重建流程,或利用场景先验来帮助重建。

3.2 重建方法

其次,文章讨论了神经场景重建方法,这些方法使用神经网络预测3D空间中点的属性。最近,一些方法使用隐式神经函数来表示场景,并能够以低内存消耗产生高分辨率的重建。

3.3 语义分割

最后,文章讨论了语义分割。最近,基于学习的方法在语义分割方面取得了巨大的进展。有一些工作旨在从3D空间实现语义分割,还有一些工作在2D和3D空间中同时学习语义分割,并利用图像和3D场景之间的投影关系来促进性能。

总之,在“相关工作”部分中,文章回顾了与本文相关的研究领域,包括多视图立体声(MVS)方法、神经场景重建方法和语义分割。

3.方法

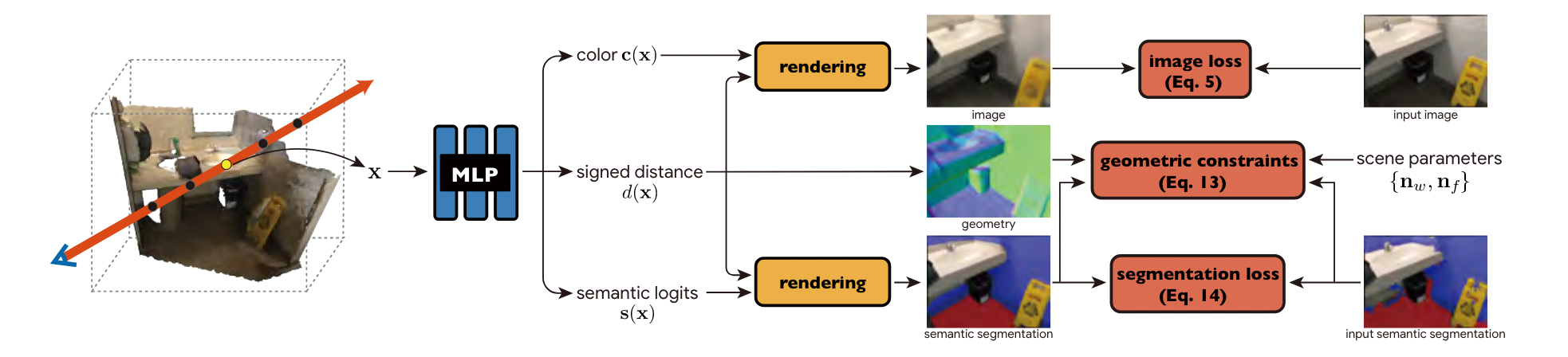

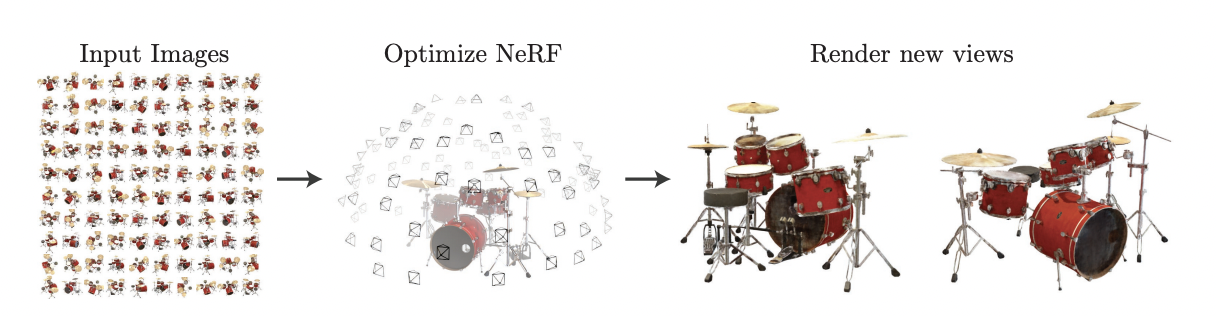

文章详细介绍了它所提出的新方法。该方法旨在从多视图图像重建室内场景的3D几何形状。该方法使用隐式神经表示来学习场景表示,并使用体积渲染技术从图像中学习场景表示网络。它还使用了2D语义分割网络来获得地板和墙壁的区域,并应用几何约束来强制平面区域中的表面点共享相同的法线方向。

具体来说,该方法使用MLP网络来预测3D空间中任意点的符号距离、颜色和语义logits。语义logits表示点为地板、墙壁或背景的概率,由2D语义分割网络初始化。

与以前的工作类似,通过将渲染图像与输入图像进行比较,学习符号距离和颜色字段。对于地板和墙壁上的表面点,我们强制它们的表面法线遵循曼哈顿世界假设。

考虑到初始分割可能不准确,我们设计了一个损失函数,同时优化语义logits和SDF。

论文使用神经隐式表示建模场景的几何、外观和语义,并从多视角图像优化该表示。具体步骤为:

1. 使用可微分体积渲染技术,根据输入图像优化几何、外观。

2. 预测墙面、地面的语义分割,并基于曼哈顿假设对这些区域采用相应的几何约束。

3. 为了提升对语义分割不准确性的鲁棒性,我们提出联合优化策略来同时优化几何和语义,从而实现更高质量的重建结果。

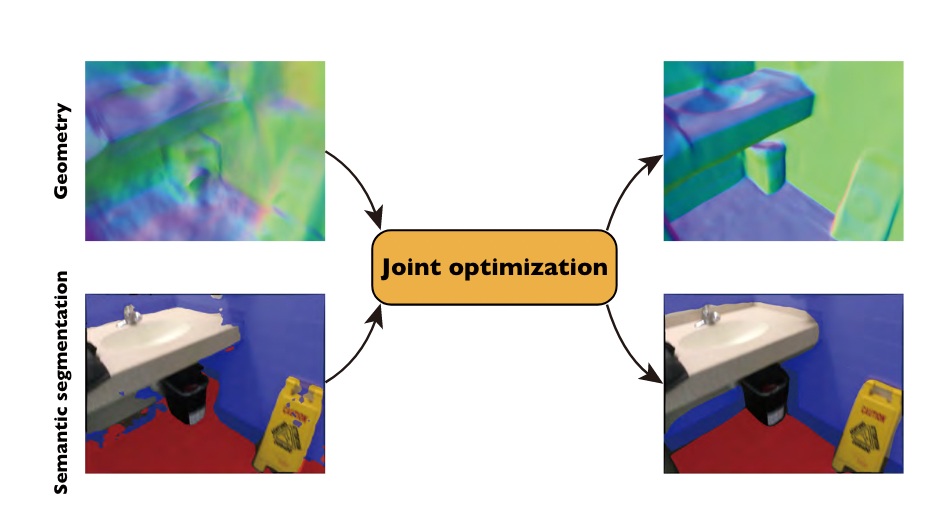

我们的方法概述。我们通过隐式神经表征学习 3D 场景的几何、外观和语义。对于图像像素,我们使用可微分体积渲染来渲染其像素颜色和语义概率,这些像素颜色和语义概率由 2D 中的输入图像和语义标签进行监督。为了联合优化几何和语义,我们基于曼哈顿世界假设在平面区域引入几何约束,从而提高了重建和分割的准确性。

总之,在“方法”部分中,文章详细介绍了它所提出的新方法,该方法使用隐式神经表示和体积渲染技术来学习场景表示,并利用2D语义分割网络和几何约束来改善重建质量。

4.实验细节

在“实现细节”部分中,文章介绍了其方法的实现细节,包括使用的软件、硬件、训练参数和过程。

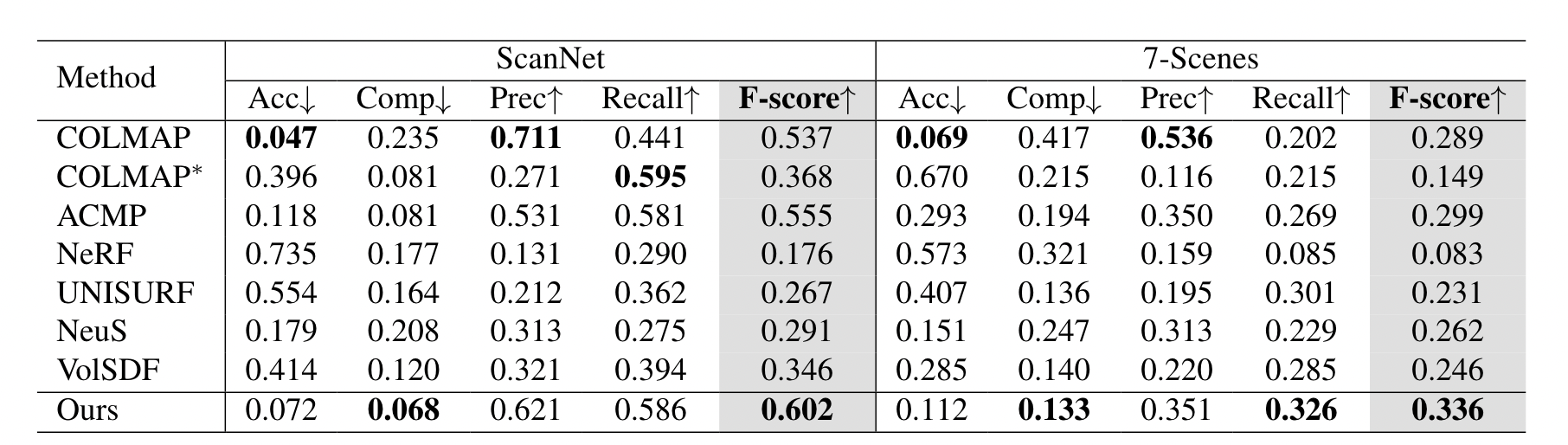

5.实验

它在ScanNet和7-Scenes数据集上进行了实验,并使用RGB-D融合结果作为真值来评估其方法。它使用5个标准指标来评估3D重建质量:精度、完整性、精度、召回率和F-分数。对于语义分割,它评估了地板和墙壁的交集比(IoU)。

文章还进行了消融研究,以展示其方法中每个组成部分的有效性。

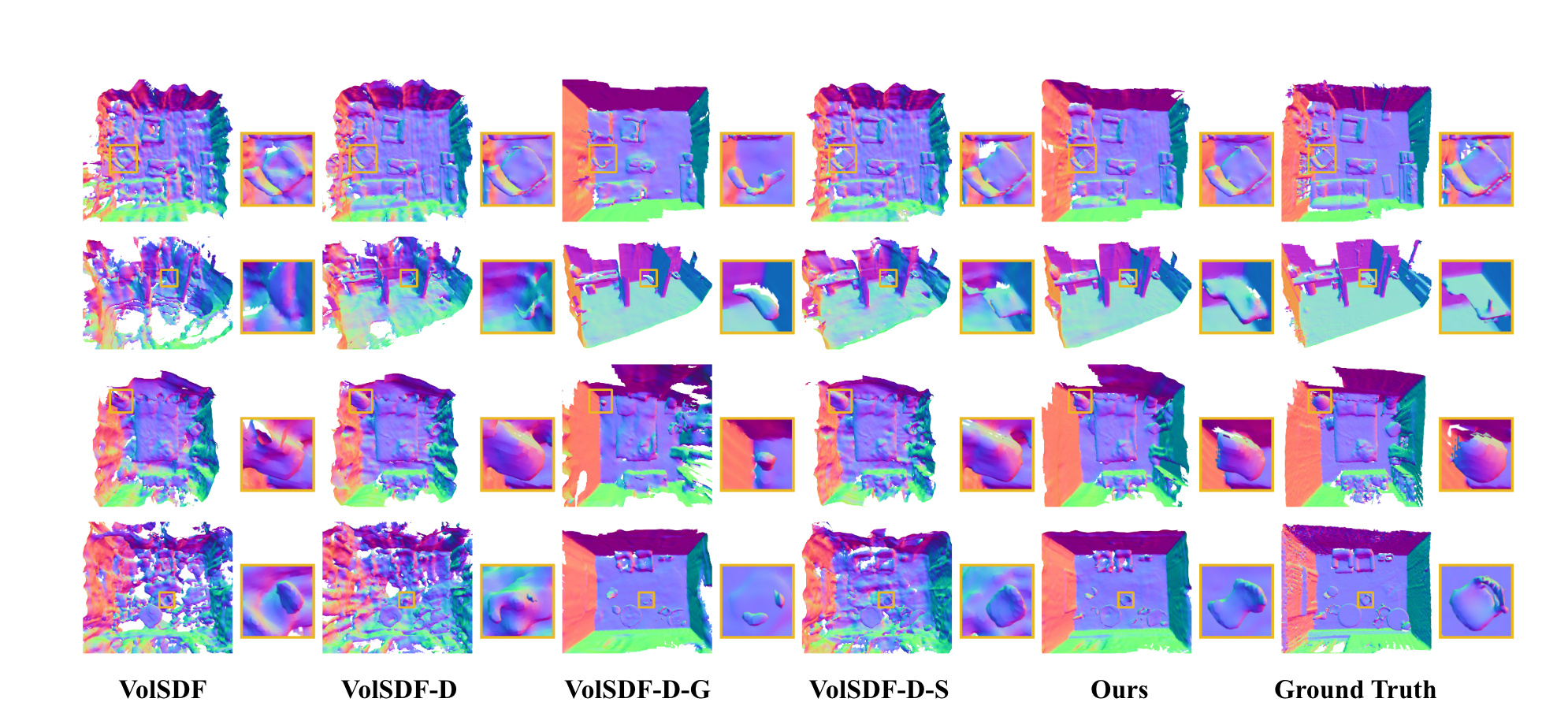

它比较了四种配置:

(1)VolSDF的原始设置:仅使用图像监督训练网络;

(2)VolSDF-D:在VolSDF的基础上添加深度监督;

(3)VolSDF-D-G:在VolSDF-D的基础上添加法线损失;

(4)VolSDF-D-S:在VolSDF-D的基础上,在3D空间中学习语义;

(5)我们的方法:在3D空间中学习语义,并将法线损失改进为联合优化损失。

实验结果表明,所提出的方法在重建精度和召回率方面显著优于现有方法。

此外,文章还将其方法与现有方法进行了比较。它与经典MVS方法(COLMAP)、MVS方法与平面拟合(COLMAP*)、MVS方法与平面正则化(ACMP)以及最先进的基于体积渲染的方法(NeRF、UNISURF、NeuS和VolSDF)进行了比较。实验结果表明,所提出的方法在重建精度和召回率方面显著优于现有方法。

ScanNet 上的消融研究。与我们的基线相比,我们的方法可以产生更加连贯的重建结果。请注意,与 VolSDF 和 VolSDF-D 相比,VolSDF-D-G 可以重建更平滑和更完整的平面。与 VolSDF-D-G 相比,我们的可以保持平面的重建质量,同时还可以在非平面区域重建更多细节。颜色表示表面法线。放大细节。

总之,在“实验”部分中,文章介绍了它所进行的实验,包括数据集、评估指标、消融研究和与现有方法的比较。实验结果表明,所提出的方法在重建精度和召回率方面显著优于现有方法。

ScanNet 和 7-Scenes 上的平均 3D 重建指标。我们将我们的方法与基于 MVS 和体绘制的方法进行比较。我们方法的准确性仅次于 COLMAP,我们的完整性与平面先验的 MVS 方法相当。考虑到准确性和完整性,我们的方法实现了最佳的重建性能。

6.总结

文章也指出了其工作的局限性。该工作仅考虑了曼哈顿世界假设。虽然大多数人造场景都遵循这一假设,但有些场景需要更通用的假设,例如亚特兰大世界假设。所提出的框架可以通过修改损失函数中几何约束的公式来扩展以采用其他假设。

请登录后查看评论内容